Spieltheorie und die Evolution des guten Menschen

Christoph Pöppe

Zwei Menschen, nennen wir sie A und B, verabreden ein Geschäft, aber aus irgendwelchen Gründen kann der Tausch Ware gegen Geld nicht persönlich stattfinden. Stattdessen soll A die Ware an einem vereinbarten Ort deponieren und B das Geld an einem anderen Ort (beide Orte werden vor dem Rest der Welt sorgfältig geheimgehalten). Später holen beide ab, was ihnen zusteht; sie kennen sich nicht und werden nie wieder etwas miteinander zu tun haben.

Wenn die beiden Beteiligten so handeln und denken, wie die klassische Wirtschaftswissenschaft es sich vorstellt, kann aus dem Geschäft nichts werden. Der homo oeconomicus der Theorie ist ein „rationaler Nutzenmaximierer“: Ihn interessiert einzig sein eigener Vorteil (den er auch in jeder Situation zu berechnen weiß); menschliche Regungen wie Mitgefühl oder ein Sinn für Fairness sind ihm ebenso fremd wie Neid, Missgunst oder Rachsucht. Mit seinen Mitmenschen hat er ausschließlich im Rahmen eines Geschäfts zu tun, und darüber hinaus muss er sie nicht kennenlernen. Es ist sogar hilfreich, wenn die Geschäftspartner nicht wissen, wie es ihm geht. Dieses Unwissen hindert sie nämlich daran, ihn zu übervorteilen, wenn er in Not ist.

In dem geschilderten Szenario denkt sich A wie B: „Wenn wir beide unsere Verabredung einhalten, habe ich einen Nutzen davon. Aber wenn ich sie nicht einhalte, habe ich den größeren Nutzen: Ware, ohne etwas bezahlt zu haben, beziehungsweise Geld, ohne etwas geliefert zu haben. Wenn der andere sie nicht einhält, ist es für mich sowieso besser, nicht zu liefern. Also ist es in jedem Fall für mich vorteilhaft, die Vereinbarung nicht einzuhalten.“

Jetzt kommt eine typische Argumentationsfigur der Spieltheorie: A denkt nicht nur darüber nach, was er selbst tun will, sondern auch darüber, was B denkt, insbesondere, was B denkt, dass A denkt, dass B denkt … Theoretisch könnte das Nachdenken über das Nachdenken über das Nachdenken … in einen unendlichen Regress ausarten, aber hier endet die Gedankenfolge sehr schnell in einem unerfreulichen Zustand, der nach seinem Entdecker John Nash„Nash-Gleichgewicht“ heißt. Beide kommen zu dem Ergebnis, nicht zu kooperieren, weil jede einseitige Abweichung von dieser Strategie zum Nachteil des Abweichlers ausschlagen würde. Natürlich könnten beide einen großen Vorteil vom Kooperieren haben, aber dazu müssten sie sich aufeinander verlassen können – was nach Voraussetzung nicht möglich ist.

In der Literatur läuft dieses viel diskutierte Problem unter einem ziemlich irreführenden Namen: Gefangenendilemma. In der zugehörigen Geschichte geht es nicht um zwei Geschäftsleute, sondern um zwei Kriminelle, die verhaftet wurden und getrennt voneinander verhört werden. Da die Beweislage dünn ist, bietet der Kommissar jedem von ihnen einen Deal an: Verpfeifst du deinen Kumpel, kriegst du Strafmilderung als Kronzeuge, und der andere wandert für fünf Jahre in den Knast. Wenn allerdings beide gestehen, war’s das mit der Kronzeugenregelung.

„Kooperieren“ heißt also in diesem Szenario „schweigen“, „nicht kooperieren“ ist „gestehen“. Und wenn die Gauner nicht durch brüderliche oder ähnliche Bande miteinander verbunden sind, kommen sie zum selben Ergebnis wie oben die Geschäftsleute: Sie verpfeifen einander – gut für die Polizei, schlecht für die Verbrecher. Um also das Gefangenendilemma im Wortsinn zu würdigen, muss man die Gaunerperspektive einnehmen, was gelegentlich zu Verwirrung führt.

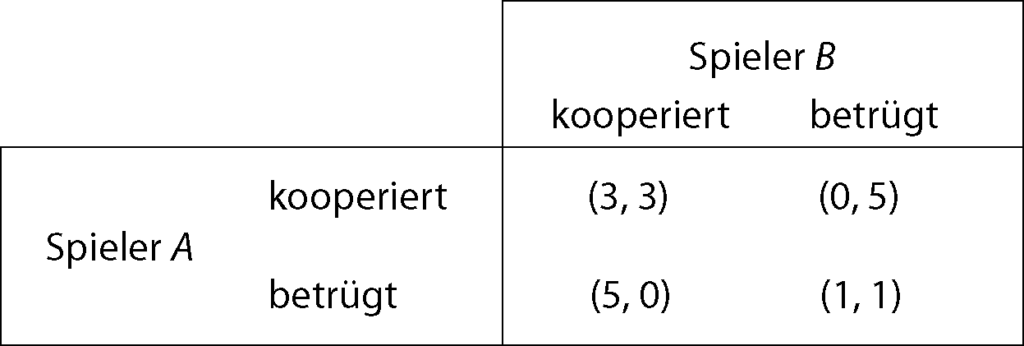

Einerlei – die Spieltheorie setzt beide Geschichten in dieselbe abstrakte Darstellung um: eine Auszahlungsmatrix. Darin ist für jede Kombination der möglichen Verhaltensweisen beider Spieler eine „Auszahlung“ verzeichnet, das ist der Nutzen, den jeder der beiden aus der jeweiligen Situation zieht, ausgedrückt durch gewisse Zahlen.

Die Auszahlungsmatrix, mit der üblicherweise das Gefangenendilemma diskutiert wird. Die erste Zahl in der Klammer bezeichnet die Auszahlung für A, die zweite für B. Beiderseitige Kooperation bringt beiden Beteiligten einen Nutzen von 3 (in irgendwelchen Einheiten), erfolgreiches Betrügen dem Betrüger 5 Einheiten, dem Betrogenen gar nichts, und wenn beide nicht kooperieren, kommen sie immerhin noch mit einer Auszahlung von 1 davon. Dabei kommt es auf die Zahlenwerte nicht besonders an. Damit das Gefangenendilemma seine Wirkung entfaltet, muss nur die Reihenfolge gewahrt bleiben: Erfolgreich betrügen ist günstiger als erfolgreich Kooperieren ist günstiger als erfolglos Betrügen ist günstiger als Betrogenwerden. Und zweimal erfolgreich Kooperieren bringt mehr ein als einmal erfolgreich Betrügen und einmal Betrogenwerden.

So weit, so schlecht. Aber wie kommt man aus der Falle des Nash-Gleichgewichts wieder heraus?

Überraschend einfach. Es genügt, wenn das seltsame Geschäft wiederholt stattfindet („iteriertes Gefangenendilemma“ oder IPD wie iterated prisoner’s dilemma). Dann nämlich lässt die Aussicht auf zukünftige profitable Geschäfte es sinnvoll erscheinen, zunächst zu kooperieren, selbst wenn man dabei einen herben Verlust riskiert. So denkt A und weiß, dass B genauso denkt; schließlich steckt der in derselben Situation. Und schon steht das bisher so feste Nash-Gleichgewicht auf der Kippe.

Nur: Ein klares Ergebnis, zum Beispiel dass es rational wäre, stets zu kooperieren, gibt die Theorie nicht her. Zu wild und unübersichtlich sind die Gedankenketten der Art „A denkt, dass B sich überlegt, A zunächst in Sicherheit zu wiegen, dann aber aufs Kreuz zu legen, woraufhin A sich vornimmt, rechtzeitig das Kooperieren einzustellen (aber wann ist rechtzeitig?) …“

An dieser Stelle kommt die Computersimulation ins Spiel. Was auch immer die Beteiligten sich denken mögen, am Ende läuft es auf eine schlichte Handlungsanweisung hinaus: Gegeben ein bisheriger Geschäftsverlauf – beim ersten Mal habe ich kooperiert, der andere aber nicht, beim zweiten Mal war’s umgekehrt, beim dritten Mal haben wir beide die Vereinbarung eingehalten …; dann sagt mir die Anweisung, ob ich diesmal kooperieren soll oder nicht. Das ist nichts weiter als eine mathematische Funktion, realisierbar durch ein Computerprogramm. Nun kann man viele verschiedene Programme gegeneinander antreten lassen und sehen, welches hinterher am besten dasteht, gemessen an der Summe der erreichten Auszahlungen.

Genau das hat der Politologe Robert Axelrod von der University of Michigan in Ann Arbor getan. Er lud 1979 etliche Fachleute ein, programmierte Strategien für das iterierte Gefangenendilemma einzureichen, und ließ sie alle gegeneinander antreten. Damit löste er eine Lawine von Forschungsaktivitäten aus, deren Ausläufer bis in die jüngste Zeit reichen.

Aus Axelrods erstem Turnier ging ein sehr einfaches Programm als klarer Sieger hervor: „Tit for Tat“, eingereicht von dem Mathematiker und Philosophen Anatol Rapoport (1911–2007), der insbesondere für seine Untersuchungen zum iterierten Gefangenendilemma berühmt geworden ist. „Tit for Tat“, zu übersetzen ungefähr mit „Wie du mir, so ich dir“, kooperiert im ersten Schritt und tut in jedem folgenden Schritt das, was der Partner unmittelbar zuvor getan hat. Auch in einem Folgeturnier, in das die Beteiligten die Erfahrungen des ersten einbringen konnten, errang „Tit for Tat“ mit deutlichem Abstand die höchste Punktzahl.

Das Ergebnis will einem zunächst nicht in den Kopf. „Tit for Tat“ kann nämlich nie eine höhere Punktzahl erzielen als sein Partner. Warum? Kooperieren beide, gewinnen auch beide je 3 Punkte. Gewinnt „Tit for Tat“ durch Betrügen, dann ist es im Zug vorher selbst betrogen worden. In der Gesamtbilanz beider Züge ist es zumindest nicht der Gewinner. Gesamtsieger wird es nur dadurch, dass es in seiner Umwelt, sprich der Gesamtheit der Turnierteilnehmer, ausreichend Gleichgesinnte findet, während die weniger gutartigen Konkurrenten zwar immer besser aussehen als ihre Partner – das ist der unmittelbare Effekt davon, dass man sich gegen das Kooperieren entscheidet –, aber es zu nichts bringen, weil auf die Dauer niemand mit ihnen kooperiert.

Eine genauere Analyse der Turnierergebnisse bringt vier Eigenschaften zu Tage, über die eine Strategie verfügen muss, um in zahlreichen Umwelten zu bestehen:

- „nett“: kooperiere im ersten Zug;

- „provozierbar“: lass dir nicht jeden Betrug gefallen;

- „nicht nachtragend“: kehre rasch wieder zur Kooperation zurück, wenn es dir angeboten wird;

- „durchschaubar“.

Was hat es mit der letzten Eigenschaft auf sich? Selbst ein primitives Computerprogramm analysiert, wenn auch in einem sehr rudimentären Sinn, das Verhalten seines Partners. Ist dieses Verhalten einfach zu verstehen, dann ist es auch den beschränkten kognitiven Möglichkeiten eines Programms zugänglich. Ja, das ist alles sehr allegorisch zu verstehen – kommen Sie jetzt bloß nicht auf die Idee, eine Diskussion darüber zu eröffnen, ob ein Programm Bewusstsein haben kann. Drücken wir es weniger vermenschelnd aus: Ein einfach gestricktes Programm kann mit größeren Erfolgsaussichten auf die Aktionen seines Partnerprogramms reagieren, wenn dieses ebenfalls einfach gestrickt ist.

Jetzt kommen die Evolutionsbiologen ins Spiel und erweitern das Turnier auf ihre Weise. Wie zuvor spielt eine bunte Mischung von Programmen jeder gegen jeden. Dann hat jedes Programm Nachkommen (Klone, um genau zu sein), und zwar proportional zur erzielten Punktzahl. Das leuchtet ein: Je fetter das Tierchen geworden ist, desto mehr Eier kann es legen. In der nächsten Generation treten die Kinder der Urprogramme gegeneinander an, und so weiter.

Schon nach wenigen Generationen dominieren die Programme, die über die vier genannten Eigenschaften verfügen, das Geschehen. Bereits ein kleines Häuflein „Tit for Tats“ gedeiht in einer übermächtigen feindlichen Umwelt und vermehrt sich, bis es die bösartigen Typen an den Rand drängt.

Wie es sich für Evolutionsbiologen gehört, bereichert man das Modell um Mutationen: In jeder Generationen werden neue Programme eingemischt, die nicht von den bereits etablierten abstammen. Dazu gehören einerseits solche, die noch viel gutwilliger sind als „Tit for Tat“, bis hin zu bedingungslos Kooperierenden. In einer Gesellschaft, in der Kooperation ohnehin Standard ist, fallen diese Typen überhaupt nicht auf.

Andererseits kann sich ein bedingungsloser Betrüger, der in einem solchen Ökosystem neu auftaucht, an den zahlreichen Naivlingen dick und fett fressen und eine kopfstarke Dynastie gründen. Die treibt ein paar Generationen ihr Unwesen, rottet die allzu Gutwilligen aus – und stirbt dann selbst aus, weil sie eben mit ihresgleichen nicht auf einen grünen Zweig kommt.

Knapp zwanzig Jahre nach Axelrods erstem Turnier haben die französischen Informatiker Jean-Paul Delahaye und Philippe Mathieu eine erweiterte Version des Turniers veranstaltet und ausführlich analysiert: „Altruismus mit Kündigungsmöglichkeit“. Jeder spielt 1000 Mal gegen jeden. Außer zu kooperieren oder auch nicht, hat man die Option, die Geschäftsbeziehung unwiderruflich zu beenden, was beiden Beteiligten zwei Punkte einbringt – für jedes Spiel, das dann nicht mehr stattfindet.

In der Analyse konnten Delahaye und Mathieu Axelrods Ergebnisse im Großen und Ganzen bestätigen: Die vier genannten Eigenschaften sind wesentlich für den Erfolg. Die evolutionären Szenarien konvergieren in aller Regel gegen den idyllischen Zustand – alle kooperieren –, und der erholt sich auch von einem Einbruch bösartiger Strategien. „Tit for Tat“ landet irgendwo im Mittelfeld; dank der komplizierteren Umwelt haben kompliziertere Strategien bessere Chancen.

Da drängen sich Schlussfolgerungen für den Umgang der Menschen miteinander geradezu auf. Es ist gut und richtig, Vertrauensvorschuss zu geben, Übeltaten zu verzeihen und auf Hinterhältigkeiten zu verzichten. Das hat frappante Ähnlichkeiten mit dem, was einem die Bibel erzählt. Nur die Begründung ist eine völlig andere: Eigennutz! Liebe deinen Nächsten, auf dass du lange lebest und es dir wohlergehe auf Erden. Nein, diese beiden Halbsätze gehören in der Bibel nicht zusammen. Aber in einer Gesellschaft, die sich den Prinzipien der Bibel verpflichtet fühlt – und sei es aus religiösen Gründen –, ist die Konvergenz zur Idylle rascher und stabiler. Denn jeder kann mit gutem Grund vermuten, dass sein Partner kooperiert.

Die Biologen finden im iterierten Gefangenendilemma eine gute Begründung dafür, dass sich Altruismus auch im Tierreich entwickelt, womit die frühdarwinistische Vorstellung vom Kampf aller gegen alle an entscheidender Stelle relativiert wird. Das gilt selbst dann, wenn von bewussten Strategien nicht die Rede sein kann. Die Menschen haben zweifellos von ihren tierischen Vorfahren einen gewissen Hang zum Altruismus geerbt. Und die Idee, dass dieses Merkmal auch heutigen Gesellschaften einen Selektionsvorteil bietet, scheint nicht ganz abwegig – was wiederum das Modell vom homo oeconomicus in Frage stellt.

Als Douglas Hofstadter (ja, der von „Gödel, Escher, Bach“) Axelrods Turnier im Mai 1983 im „Scientific American“ (auf Deutsch im August 1983 im „Spektrum der Wissenschaft“) vorstellte, nahm er derartige Schlussfolgerungen zum Anlass, eine kooperative Grundhaltung den beiden Herren nahezulegen, die am Drücker für die Atomwaffen saßen; die hießen damals Reagan und Andropow. Vor einem Jahr hätte man wahrscheinlich mit derselben Begründung gegen Trump argumentieren können.

Ja, solche Schlüsse von einem Computerturnier auf menschliche Gesellschaften sind äußerst problematisch. Der Siegeszug der kooperativen Verhaltensweisen ist zwar eindrucksvoll, aber stets abhängig von der Umwelt, in der diese Verhaltensweisen sich behaupten müssen. Und offensichtlich ist eine menschliche Gesellschaft sehr verschieden von ihrer primitiven Karikatur, die durch diese einfachen Computerprogramme verkörpert wird.

Gleichwohl bin ich überzeugt, dass Mathematik die Welt verbessern kann, und zwar auf einem ungewöhnlichen Umweg: indem sie den Menschen am – brutal vereinfachten – Beispiel demonstriert, dass edel, hilfreich und gut zu sein dem eigenen Wohlergehen förderlich ist.

Quellen

Douglas R. Hofstadter: Metamagical Themas. Darin Kapitel 29 „The Prisoner’s Dilemma. Computer Tournaments and the Evolution of Cooperation“. Basic Books, New York 1985. Erweiterter Abdruck der gleichnamigen Rubrik aus Scientific American, Mai 1983.

Deutscher Erstabdruck: Douglas R. Hofstadter: Metamagikum. Spektrum der Wissenschaft, August 1983, S. 8. Neu übersetzt als Kapitel in dem Buch Douglas R. Hofstadter: Metamagicum. Fragen nach der Essenz von Geist und Struktur. Klett-Cotta, Stuttgart 1993.

Robert Axelrod: The Evolution of Cooperation. Revised Edition, Basic Books, New York 2006. Deutsch: Die Evolution der Kooperation. 7. Auflage. Oldenbourg, München 2009

Mathematische Spiele und Strategien. Mathematische Unterhaltungen V. Sonderheft Spektrum der Wissenschaft; enthält Artikel der Rubrik „Mathematische Unterhaltungen“ zum Thema Spieltheorie. Neu aufgelegt als „Highlights 1/2021“.

The post Spieltheorie und die Evolution des guten Menschen originally appeared on the HLFF SciLogs blog.